英伟达Rubin芯片:288GB HBM4+50P算力

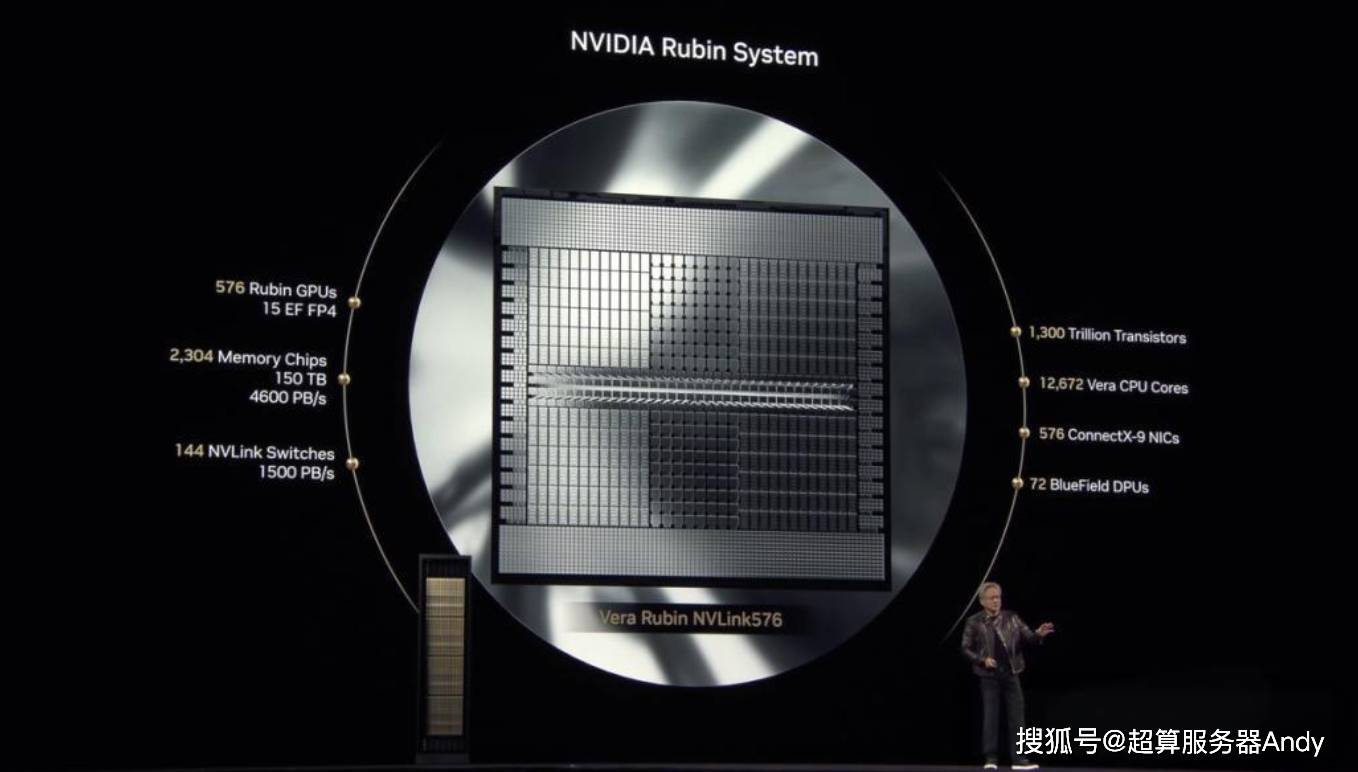

当黄仁勋在COMPUTEX 2025上抛出“Rubin GPU+Vera CPU”组合时,全球科技圈的惊叹声几乎掀翻屋顶——288GB HBM4显存、50 Petaflops推理算力、一年一迭代的疯狂节奏,英伟达用最硬核的方式宣告:AI算力战争进入“核武器时代”!这颗以暗物质研究先驱命名的新芯片,究竟是噱头还是真革命?本文带你拆解五大颠覆性真相,看完你或许会明白:为什么有人说“2026年之后,AI产业将没有显存焦虑”。

一、性能怪兽:参数碾压式升级,HBM4成“物理外挂”

1. HBM4:13TB/s带宽,千亿模型直接“装进”芯片

传统GPU的痛点是什么?显存不足导致大模型必须拆分训练。而Rubin的HBM4显存带宽高达13TB/s,相当于每秒传输2600部4K电影!这意味着什么?

- 案例:DeepSeek R1-671B模型(6710亿参数)加载速度提升10倍,推理延迟从秒级压缩到0.02秒,直接让实时对话AI成为可能。

- 技术本质:HBM4采用3D堆叠+混合键合技术,单位面积内存容量是HBM3的2.4倍,堪称“显存界的摩天大楼”。

2. Vera CPU:88核定制Arm,打破CPU-GPU“结界”

英伟达首次将CPU与GPU深度耦合:

- 88个定制Arm核心+75TB内存,专为AI工作负载优化;

- 协同设计:通过NVLink 5.0实现CPU-GPU零延迟通信,整体性能较Blackwell架构翻倍。

- 隐喻:如果说Rubin GPU是“核动力引擎”,Vera CPU就是“智能调度员”,彻底解决数据搬运的“最后一公里”瓶颈。

3. 迭代革命:一年一更,技术代差碾压对手

aspcms.cn英伟达将芯片迭代周期从2年压缩至1年,2027年Rubin Ultra将冲击15 Exaflops算力(1 Exaflops=1000 Petaflops)。对比AMD MI300X的3.8 Exaflops,这已不是升级,而是“降维打击”。

二、AI工厂心脏:服务器与算力租赁的“双重革命”

1. GB300服务器:单机柜3.6 Exaflops,能耗暴降40%

- 架构突破:单台GB300支持144颗Rubin GPU,可同时训练3个万亿参数模型(GPT-4仅支持1个);

- 能耗黑科技:采用液冷+动态电压调节技术,每瓦性能较Blackwell提升40%,直接击中数据中心“电费焦虑”痛点。

- 产业信号:富士康、和硕已启动量产,2026年全球AI服务器市场规模预计突破2600亿元,中国华东地区将贡献60%产能。

2. 算力租赁暴跌:成本仅为GPT-4的1/20

- 经济账:Rubin推理成本断崖式下降,配合NIM微服务,企业部署AI应用时间从数周缩短至几分钟,开发成本降低76%;

- 天基算力网:英伟达与SpaceX合作,通过“三体计算星座”卫星实现“天感天算”,深空探测数据延迟从天级压缩到秒级。

三、行业重塑:从数字人到机器人,万亿市场被改写

1. 数字人革命:ACE技术+Rubin,以假乱真时代来临

- 医疗场景:AI医生可实时模拟表情、语气,患者依从性提升50%;

- 客服场景:数字人对话流畅度突破“恐怖谷效应”,企业人力成本下降80%。

2. 工业4.0:富士康效率革命,年能耗降30%

- 墨西哥工厂案例:用Rubin训练机器人,复杂服务器组装效率提升30%,年能耗降低30%;

- 技术核心:通过强化学习优化机械臂轨迹,精度达0.01毫米级。

3. 自动驾驶:毫秒级决策,事故率或降40%

- 通用汽车合作:Rubin系统实现环境感知与决策同步,道路突发情况响应速度进入毫秒级;

- 数据支撑:模拟测试显示,搭载Rubin的车辆在极端天气下避障成功率提升65%。

四、生态护城河:CUDA 15.0+量子计算,对手难以复制

1. CUDA 15.0:500万开发者的“隐形壁垒”

- 兼容性:现有500万开发者可无缝迁移至Rubin,开源模型下载量突破百万;

- 垂直渗透:金融风控、智能制造等领域爆发式增长,某银行用Rubin将反欺诈模型训练时间从7天压缩至9小时。

2. 量子计算布局:为未来十年“埋雷”

- cuQuantum平台:Rubin已兼容量子-经典混合计算,材料科学模拟效率提升1000倍;

- 战略深意:通过“经典+量子”双线并进,提前锁定下一代算力话语权。